Market Status

TrendForce預估今(2023)年AI伺服器(包含搭載GPU、FPGA、ASIC等)出貨量近120萬台、 年增38.4%,占整體伺服器出貨量近9%MIC预估,2024年全球AI服务器出货量为194 万台、2025年达236万台,一路成长至2027年320万台,年复合成长率(CAGR)为24.7 %。

AI Server Power Consumption

AI服务器的广义定义是指搭载 AI 芯片(如GPU/ FPGA/ ASIC芯片)的服务器,相对狭义的定义则是至少搭载一颗 GPU 的服务器被视作是 AI 服务器。由于AI算力的需求攀升,使得芯片耗电功率也不断升级,一台AI服务器需要2 颗CPU与4至8颗的GPU,GPU又是CPU功率的2至4倍。 NVIDIA的 AI 处理器H100的峰值功耗高达 700 瓦,加上储存装置、网络设备等,运作AI应用程序的机柜功耗可能超过30kW。 一个普通服务器机架的平均功耗为7kW。

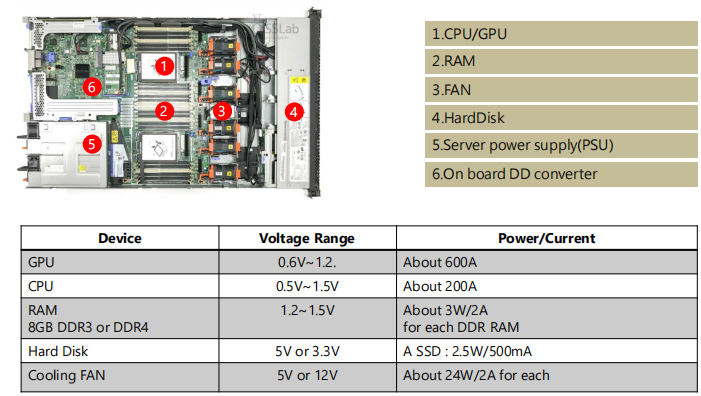

AI服务器各装置电压/功率规格

服务器主板上的DD电源模块测试

研发端测试: Input/Output的 ripple测试, OCP, 效率, Input/Output OVP, 输出时序, Dynamic, Input drop 也会利用VRTT tool这样的治具,来实际模拟CPU等系统拉载特性测试。该VRTT tool上面会有量测 点供仪表量测,也可以从VRTT tool的软件读取相关测试数据。

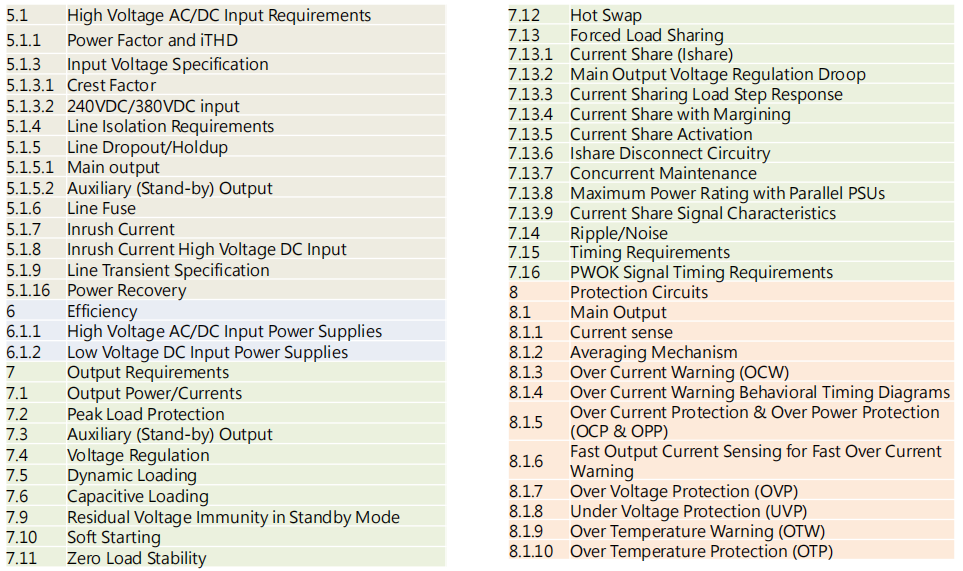

M-CRPS规范测试项目-High Voltage AC/DC Input Requirements

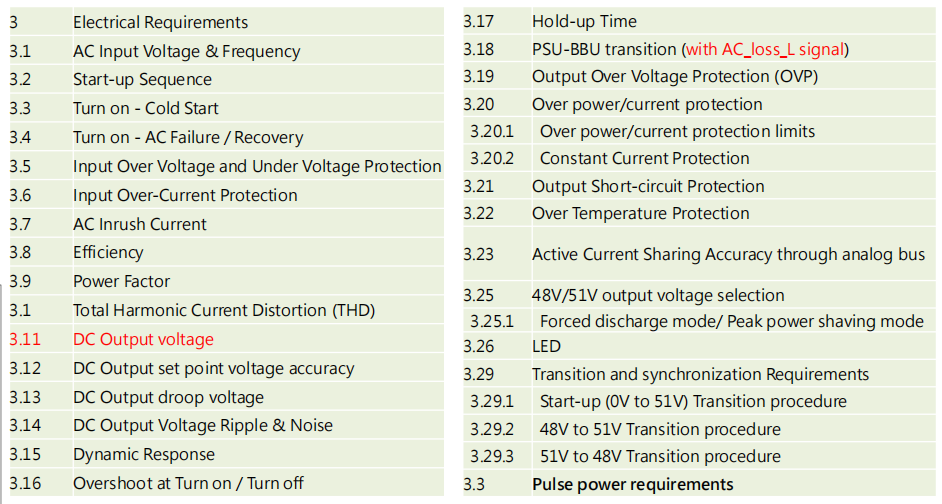

ORV3规范测试项目- 51V/50V/48Vout PSU

测试设备

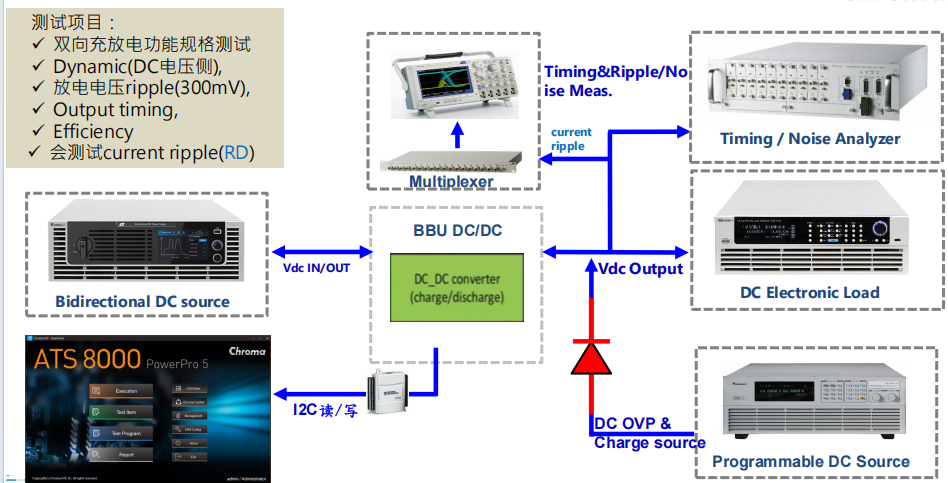

BBU 双向DC/DC converter测试方块图